Se na modernidade a “imaginação” era um fator negativo à objetividade da produção do saber — a contemporaneidade ressalta o seu aspecto positivo … que se caracteriza pela crítica e criatividade, na busca e desenvolvimento de uma… “verdade científica”.

A partir de uma breve abordagem histórica da ciência, levando em conta seus aspectos culturais e históricos … da ‘modernidade’ à ‘contemporaneidade’… – poderemos então começar a refletir – sobre como acontece o intercâmbio…“imaginação/ciência” – para isso definindo sua importância nesses dois momentos distintos da ‘produção do saber’.

A partir de uma breve abordagem histórica da ciência, levando em conta seus aspectos culturais e históricos … da ‘modernidade’ à ‘contemporaneidade’… – poderemos então começar a refletir – sobre como acontece o intercâmbio…“imaginação/ciência” – para isso definindo sua importância nesses dois momentos distintos da ‘produção do saber’.

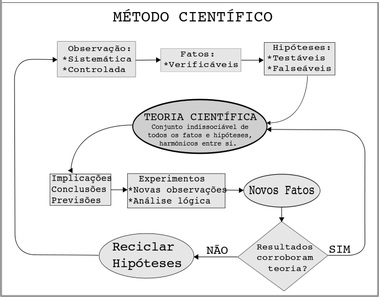

Na modernidade — a “imaginação” era um fator negativo no desenvolvimento da verdade científica. — Hoje em dia … mesmo continuando a seguir os caminhos da… “objetividade”, partimos do pressuposto dessa ‘imaginação’ … como uma peça importante no processo de construção do conhecimento científico, dentro de uma metodologia “hipotético-dedutiva”. Todavia, para justificar essa assertiva, devemos antes definir o seu próprio significado – e determinar em que momento ela, de fato, se torna parte integrante do “método científico”.

Considerada um processo criativo com o objetivo específico de solucionar problemas, a imaginação, nessa perspectiva, se manifesta por seus pressupostos – tanto no processo de desenvolvimento científico … quanto na solução de problemas práticos do cotidiano; partindo de hipóteses (representações mentais), visando soluções teóricas…que devem ser colocadas à prova…para confirmar sua efetividade prática. A imaginação a qual nos referimos, foi caracterizada pela pesquisadora Marcia Pereira (UFRJ) em sua tese – de 2009, levando em conta os aspectos culturais e históricos do cientista … caracterizados, a partir do nascimento de uma ideia, pela busca incessante da verdade e conhecimento.

Segundo ela, o termo “imaginação científica” foi cunhado – em circunstâncias distintas, pelos físicos Jorge Wagensberg Lubinski e Gerald Holton. Em ambos os casos, a ciência é compreendida como a consequência de uma “imaginação eficaz”, voltada a solucionar uma questão que não encontra ‘respostas satisfatórias’ – em teorias e métodos vigentes.

A AUSÊNCIA DA IMAGINAÇÃO NO MÉTODO INDUTIVO “A imaginação criativa atrapalhava a correta visão da realidade…e, portanto, deveria ser eliminada por quem quisesse ter uma atitude ‘científica’. – Fazer ciência era assumir uma atitude passiva de espectador da realidade” (Köche)

O filósofo José Carlos Köche apresenta em seu livro … “Fundamentos da Metodologia Científica” (2013) … momentos distintos e particulares do…’conhecimento científico‘. Partindo dos ‘filósofos pré-socráticos’ … e passando Aristóteles…até chegar à ciência moderna e contemporânea, ele traz numa ‘abordagem histórica‘, o desenvolvimento da ‘ciência natural’, e ‘métodos científicos’.

Todavia, aquilo que entendemos hoje como “ciência” – teve início na modernidade…no século 17, teoricamente, com Francis Bacon e…empiricamente… — com…Galileu Galilei.

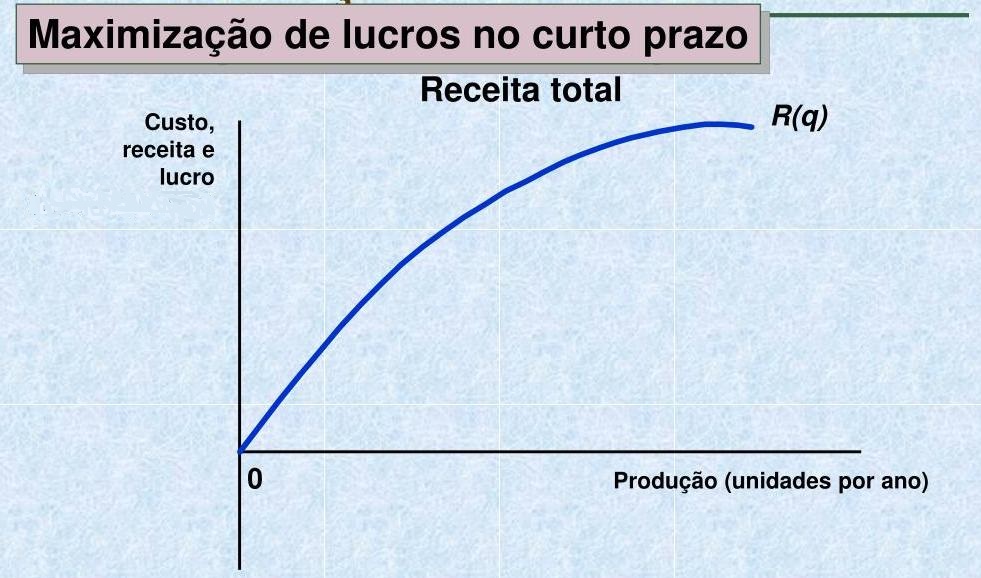

Sobre esse período de desenvolvimento do método científico…compreendido entre a ciência moderna e contemporânea, Köche destaca 2 momentos distintos: o emprego de diferentes métodos pela ciência, no seu processo de produção de conhecimento, e a busca pela verdade. Estamos aqui nos referindo ao “método indutivo experimental” e ao “método hipotético-dedutivo” – os quais formaram os dois grandes paradigmas científicos que, definitivamente, estabeleceram novos rumos para a ciência…em sua procura da verdade, com também à sociedade … e a vida humana de um modo geral.

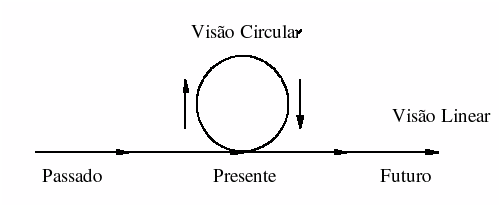

É certo que a ciência moderna com seu método indutivo experimental causou uma revolução na busca pelo conhecimento…mas também é possível compreender que, de algum modo, este mesmo método acabou por propiciar a estagnação da ciência, através do seu dogmatismo; como explica Köche: “O progresso da ciência era visto como o acúmulo progressivo de teorias e leis, que se juntavam umas às outras. Era um progresso linear, contínuo, sem retorno…fundamentado em verdades cada vez mais estabelecidas…e confirmadas definitivamente”. – Nesse sentido…pelo fato da ciência não ser tratada como produto do “espírito humano” – mas sim…através da constatação e explicitação de leis…’imaginação’ e ‘criatividade’ não estão presentes. Neste processo de acúmulo progressivo de teorias, a imaginação era um empecilho.

O fato curioso e um tanto quanto paradoxal, é que aquilo que a ciência moderna trouxe de inovação…a partir do método de ‘indução experimental’…é uma mudança profunda no que diz respeito à compreensão teórica do mundo. — A partir daí… o conhecimento, que passou a se caracterizar como ciência — do método científico da “experimentação”, trouxe as “verdades evidenciadas”. Esta mudança ocorreu após as críticas de Bacon ao “empirismo ingênuo“, junto ao “aristotelismo”, e sua concepção essencial de “verdade”, atrelada aos ‘preconceitos religiosos’ … o que impedia uma realística “visão de mundo”, impactando no resultado final da pesquisa, quer dizer…na interpretação da “natureza”.

Francis Bacon, Galileu Galilei…e o Método experimental Estas etapas, como sabemos hoje, estão relacionadas à necessidade do controle na experimentação. – O cumprimento destas exigências foi o que suplantou as falhas da “indução ingênua” de Aristóteles…prezando pela confiabilidade dos resultados.

Ao criticar a indução por ‘enumeração ingênua’ de Aristóteles (generalização da observação de alguns casos particulares semelhantes), Bacon propõe a “indução experimental“…uma forma mais sistematizada. O seu…”método científico” exigia os procedimentos de…‘experimentação‘, criação de ‘hipóteses‘, novas experimentações por outros cientistas – para a testagem dessas hipóteses…e generalizações, em busca de ‘leis’.

Ao criticar a indução por ‘enumeração ingênua’ de Aristóteles (generalização da observação de alguns casos particulares semelhantes), Bacon propõe a “indução experimental“…uma forma mais sistematizada. O seu…”método científico” exigia os procedimentos de…‘experimentação‘, criação de ‘hipóteses‘, novas experimentações por outros cientistas – para a testagem dessas hipóteses…e generalizações, em busca de ‘leis’.

Apesar de Bacon ter sido o primeiro a esboçar os procedimentos do método científico moderno, quem primeiro o experimentou foi Galileu – que por isso é considerado, na prática, o primeiro cientista moderno, e iniciador da ‘revolução científica’. Rejeitando o modelo aristotélico da demonstração simples – a partir de argumentos lógicos, e da ‘verdade sintática’, Galileu seguiu um caminho diferente daquele proposto por Bacon, buscando explicações na própria natureza…e introduzindo a “linguagem matemática” na ciência…utilizando-se do método quantitativo experimental, para testar hipóteses.

Galileu estabelece o “diálogo experimental” como o diálogo da razão com a realidade, do homem com a natureza, tomando como pressuposto que…fenômenos da natureza se comportam segundo “princípios”…que estabelecem relações quantitativas entre si; com os movimentos dos corpos definidos por relações numericamente determinadas.

A visão de universo de Galileu era um mundo aberto…mecânico, unificado, determinista, geométrico e quantitativo. Com a publicação da obra “Siderius Nuncius” (“O mensageiro das estrelas”) em 1610, teve início o processo de mecanização/matematização do mundo, processo este que será intensificado por Isaac Newton, com seu “Principia Mathematica”, publicado em 1687. A partir de então, foi intensificada a utilização das leis mecânicas na pesquisa científica. Com sua aplicação metodológica “independente” do pesquisador – a ciência atinge o seu grau máximo na resolução de problemas…e, com isso, um certo tipo de neutralidade/imparcialidade, visando a “eliminação do erro”, e garantia da “verdade”.

Mudando de paradigma “O experimento da física, seguindo a teorização coerente com o paradigma newtoniano, passou a ser o ‘modelo ideal’ que deveria ser copiado por todas outras áreas do saber. A partir dele foi estabelecido, na prática científica…certo dogmatismo científico”. (Köche)

Por longo tempo se propagou/perdurou na ciência o método científico ‘indutivo-confirmável‘…provindo do pensamento de Bacon, e da…”indução confirmalista” de Newton. – Tal método… por sua vez, deu origem ao…“positivismo científico”, que predominou também em diferentes campos do saber … por bastante tempo. Foi com a física que teve início a ciência moderna, de onde seu ‘método indutivo experimental’… – “dominava o mundo”.

E foi também a partir da própria física … que surgiu o rompimento com esse paradigma, e o estabelecimento de um outro – que perdura até os dias atuais – a partir da utilização do método “hipotético-dedutivo”. – Este método, que – de certa forma… é o responsável pelo caráter mais crítico e criativo da ‘ciência contemporânea’. Não estamos defendendo, é bom que se diga, que os cientistas modernos não se utilizaram da imaginação em suas descobertas científicas (o que seria absurdo)…mas estamos sim, destacando o ímpeto da ciência moderna em fugir do… “recurso imaginativo” – compreendendo-a como algo até anticientífico – assim como os conhecimentos oriundos dos sentidos, e do senso comum.

Seguindo as pistas do filósofo Alexandre Koyré, a preocupação em demarcar os limites entre experiência e experimento, demonstra bem o espírito da “era moderna”. A noção de experimento pressupõe a aceitação da geometrização da realidade…e, portanto, sua abordagem quantitativa. – Fazer ciência … daí em diante, seria estabelecer relações de valores que poderiam estar presentes por trás dos fenômenos…ou dos fatos, e testá-las. Experimento, portanto, pressupunha pensamento teórico, elaborado a priori, expresso em linguagem matemática e acrescido de teste. Neste caso, o “laboratório” que Galileu utilizou para realizar aprioristicamente seu experimento – foi seu próprio pensamento. E assim…para evitar qualquer tipo de aproximação — na produção do…”conhecimento científico moderno”, entre pensamento e imaginação, Koyré se encarrega de esclarecer a distinção entre “pensar” e “imaginar”…dando à “imaginação” um sentido totalmente diferente do que empregamos até aqui – através do exemplo paradigmático de Galileu:

“Mas, de fato, não podemos pensar no movimento no sentido do esforço e do impetus; nós o podemos apenas imaginar. Portanto, temos de escolher entre pensar e imaginar”.

Pensar com Galileu…ou imaginar com o senso comum; é pois o pensamento puro e sem mistura, e não a experiência e a percepção dos sentidos, que – segundo Koyré, constitui a base da “nova ciência” de Galileu Galilei. Ao tratar da ‘ciência mecânica’ e matemática, tanto Galileu e Kepler, quanto Newton – utilizaram-se primeiro das ideias – e depois da matemática em seu processo de criação científica. Ou seja, neles as ideias vêm antes das “expressões matemáticas”. Estas surgem depois … objetivando organizar o pensamento.

A imaginação, portanto, não era um aspecto constitutivo na ciência moderna indutiva, por ser considerada algo negativo no processo científico. Neste contexto, a imaginação prejudicaria o acesso à ‘verdade‘ dificultando os próprios experimentos da ciência. Tal preocupação explica a ausência da imaginação no exercício da ciência indutiva; sendo esta a razão pela qual…ao tratar dos achados de Galileu, Koyré distingue ‘pensamento’ de ‘imaginação’…elevando o pensar, e limitando a imaginação a algo inferior à ciência.

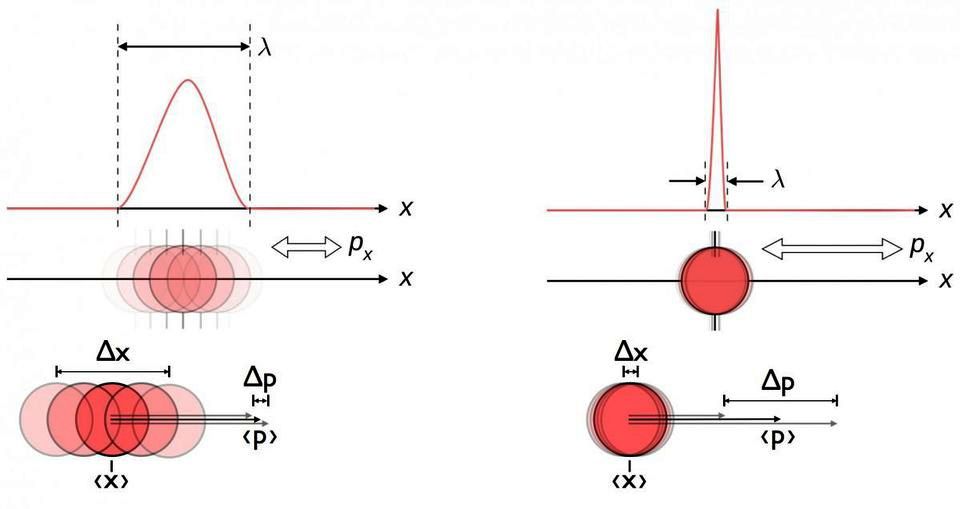

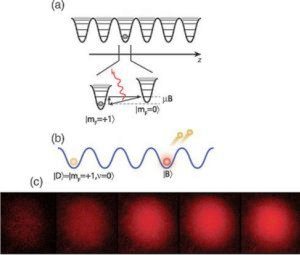

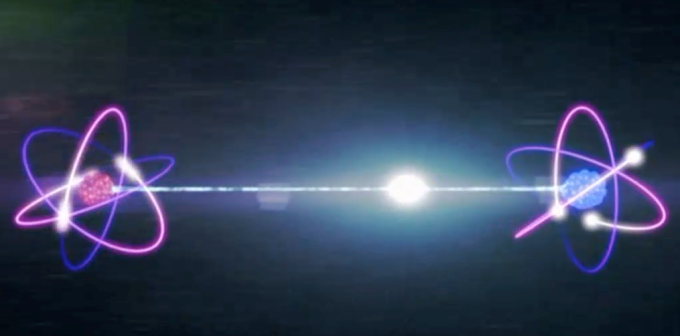

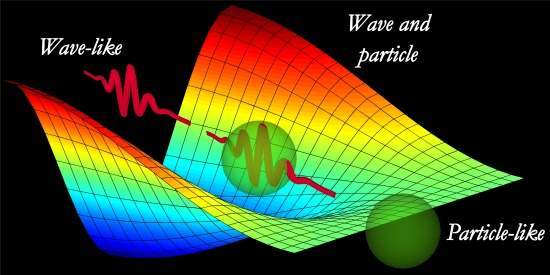

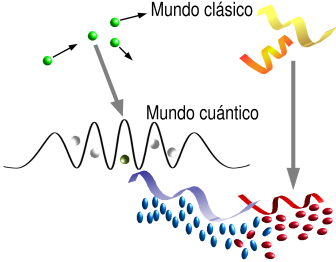

A ‘IMAGINAÇÃO’ COMO PARTE DO MÉTODO HIPOTÉTICO-DEDUTIVO É justamente no interior da física que se dá uma ruptura com o paradigma científico (dogmático) moderno…vigente até então, e se inicia o paradigma da ciência crítica e criativa … com o surgimento da “mecânica quântica” — e da teoria da “relatividade”.

O método hipotético-dedutivo mostra justamente o contrário do pensamento que pairava na ciência moderna através do ‘método da indução’. Um dos primeiros responsáveis por esta revolução — foi o físico Pierre Duhem … como assim explica Köche:

“Os métodos usados no fazer científico, são como ‘convenções articuladas’ … no contexto histórico-cultural, permitindo a renovação e progresso das teorias, bem como revelando o ‘caráter dinâmico’ dos princípios epistemológicos do conhecimento”.

A análise da história da ciência permite que Duhem discorde de Newton, desmistificando o positivismo calcado no empirismo e indução do “método newtoniano”…Sobre o “problema da indução“, Karl Popper diz: “Muitos creem que a verdade desses enunciados universais é conhecida pela experiência – contudo, a descrição de uma experiência, observação…ou seu resultado experimental, deve ser um enunciado singular … e não um enunciado universal”.

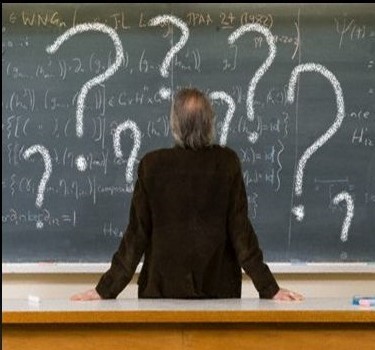

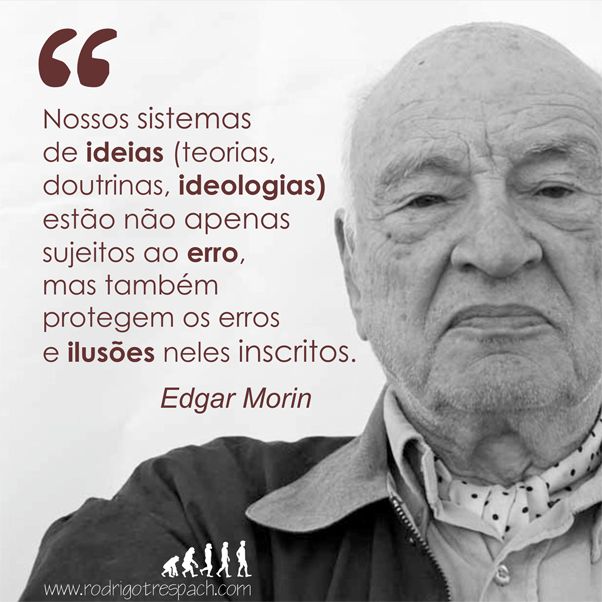

Ao apontar os problemas do ‘método indutivo’, Popper compreende que o pensamento hipotético-dedutivo desmistificou o pensamento vigente até então, qual seja, de que na ciência há somente “regras padronizadas” para se descobrir a verdade … ou solucionar problemas. De acordo com o filósofo…não há como garantir uma verdade irrefutável e irredutível na ciência. E isso se explica porque … não sendo a ciência construída de um modo linear e cumulativo, a ‘verdade científica’ está sempre sujeita a…”refutabilidade”.

Assim… Popper defende a tese de que o ‘conhecimento científico‘ deve se sustentar no “princípio da falseabilidade”…no intuito de identificar e eliminar erros – e promover o avanço da ciência. Isto o leva a afirmar que…na ciência não há verdades incontestáveis (absolutas), pois tais verdades serão sempre hipotéticas e provisórias. A ciência, então, não ficaria mais “engessada” num único método, com cada problema a ser investigado exigindo a aplicação de um método diferente. – Para Popper, desde sempre…a ciência surgiu de um problema, e das tentativas em resolvê-lo, partindo de teorias e hipóteses.

A ciência é construída por uma sucessão de superação de teorias … ao longo da história. Nela, não conhecemos as certezas, mas sim, através de inúmeras tentativas…o erro. Foi assim que os homens, e os outros animais, aprenderam ao longo da história… com seus erros. Por esta simples razão o erro não é um mal a ser evitado, muito menos na ciência.

A imaginação na construção do conhecimento científico “A solução do problema ou a explicação do fato, depende das conjecturas inventadas pelo pesquisador à luz do conhecimento disponível. – Jamais… da observação ou classificação desprovida de hipóteses. – Pois, à hipótese, cabe a função de guiar a observação” (Köche)

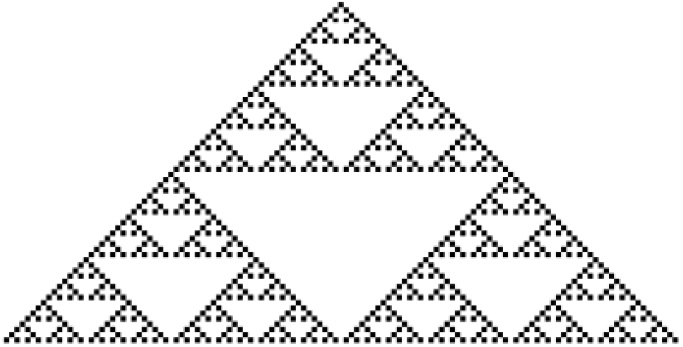

Na obra: “A lógica da pesquisa científica“, Popper afirma que a ciência progride de 2 modos: por seguidas revoluções…a partir da deteção, em teorias existentes, de seus erros…ou quando tais teorias se mostram insuficientes para resolver… “problemas”. A história do progresso científico; afirma Köche… corrobora a tese de Popper: “Foi assim que Galileu modificou a ‘mecânica’ de Aristóteles; o mesmo fez Einstein com as teorias de Newton”… E assim, evolui a ciência – na revisão e eliminação de seus erros – e pela audácia dos pesquisadores, no esforço em formular ‘novas hipóteses‘.

Na obra: “A lógica da pesquisa científica“, Popper afirma que a ciência progride de 2 modos: por seguidas revoluções…a partir da deteção, em teorias existentes, de seus erros…ou quando tais teorias se mostram insuficientes para resolver… “problemas”. A história do progresso científico; afirma Köche… corrobora a tese de Popper: “Foi assim que Galileu modificou a ‘mecânica’ de Aristóteles; o mesmo fez Einstein com as teorias de Newton”… E assim, evolui a ciência – na revisão e eliminação de seus erros – e pela audácia dos pesquisadores, no esforço em formular ‘novas hipóteses‘.

Percebemos então – que a elaboração de teorias e a construção de hipóteses são as etapas científicas mais sujeitas à imaginação. É possível sustentar isso também a partir da crítica que Carl Hempel faz ao ‘método indutivo’ – por este impedir o mecanismo da imaginação. Para Hempel, não existem… “regras de indução” — aplicáveis em geral, mediante as quais hipóteses ou teorias sejam mecanicamente derivadas ou inferidas dos…”dados empíricos”. A transição dos dados à teoria requer uma…“imaginação criadora“. As hipóteses e teorias científicas não são derivadas dos fatos observáveis…mas inventadas… a fim de explicá-los. No seu esforço para achar a solução do problema…o cientista pode soltar as rédeas de sua imaginação…podendo o rumo do seu pensamento criador ser influenciado até por noções cientificamente discutíveis. – Nada disso põe em risco a “objetividade científica”…pois as hipóteses e teorias que podem ser livremente inventadas/propostas … não são aceitas, se não passarem pelo… “escrutínio crítico” – especialmente pela verificação das implicações capazes de serem observadas e experimentadas. Com efeito, imaginação e ‘livre invenção’ são ambas relevantes em áreas cujo resultado só é legitimado pelo…”raciocínio dedutivo”.

Todo o desenvolvimento até aqui nos leva a crer que o desenvolvimento da ciência atual está ancorado em dois polos: um subjetivo…aquele que cria, que inventa, que questiona, que projeta, e constrói com a imaginação a representação de seu mundo, de acordo com as necessidades internas do pesquisador – o outro, o objetivo…que se serve de testes…e confronto. Em ambos há leis, regras, progresso. Tal constatação ajuda a compreender o processo radical que passou a ciência nos últimos tempos, e o quanto somos implicados por estas transformações. É portanto impossível suprimir a imaginação…uma vez que o ‘espírito humano‘ se projeta em tudo que faz, com toda a sua carga cultural e ideológica.

CONCLUSÃO “Não há como fazer ciência deixando de fora o ser humano, e tudo o que ele carrega consigo; cultural e historicamente”.

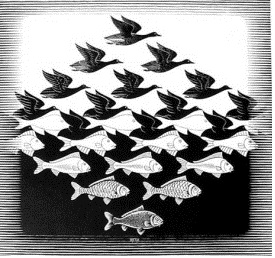

Partindo de um conceito amplo de imaginação, aquele apresentado por Jacob Bronowski, em alguns elementos, no interior da história da ciência, fica explícito a distância — como também a aproximação entre arte e ciência. – A ciência, como não poderia deixar de ser, também é afetada pela cultura e história … mas isso não quer dizer que comporta e aceita tudo, indiscriminadamente. É dentro desse longo processo aproximação/distanciamento, que percebemos a crítica de Thomas Kuhn – em… “A estrutura das revoluções científicas” (versão 2011), segundo a qual, a aproximação entre ciência e arte não surtiria efeito…por serem empreendimentos totalmente distintos… – tanto em suas produções … quanto em resultados finais. No entanto, se a crítica é válida, também deve ser a constatação de que: sendo o homem que realiza ambas as produções…não é possível exigir que deixe atrás de si, algo de sua cultura e sua história; como exigia o método científico em seus primórdios.

O ‘ser humano’ sempre resolveu seus problemas de ‘modo criativo’; a história das descobertas científicas está repleta de exemplos de cientistas que se sobressaíram e fizeram história…ao dar espaço à sua imaginação. A prática da ciência na forma de resolução de problemas, não pode deixar de lado a criatividade, na introdução de hipóteses…ou na busca por soluções. – O “desafio final” consiste em conseguir integrar “imaginação” ao domínio científico. (Adenaide Amorim Lima) texto base ****************************************************************************

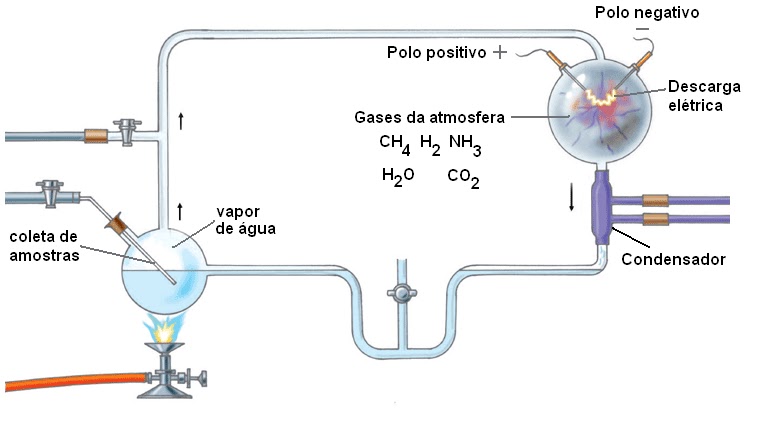

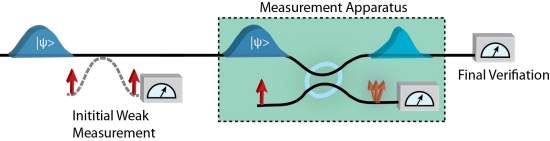

A Natureza dos “Experimentos Mentais”, e a Epistemologia envolvida O que são ‘experimentos mentais’?…eles podem ser uma fonte de conhecimentos do mundo natural?…e, de onde vem esse conhecimento?… Mais que ornamentos intelectuais, efetivamente os EMs são usados para gerar conhecimento científico.

Na literatura existem diferentes “modos de interpretação”…com decisões e concepções distintas para as questões propostas. Ernst Mach — por exemplo, foi um dos pioneiros na discussão sistemática do assunto… Para ele, o ‘experimento mental‘ é pré-condição necessária à uma… ‘experimentação física‘.

Na literatura existem diferentes “modos de interpretação”…com decisões e concepções distintas para as questões propostas. Ernst Mach — por exemplo, foi um dos pioneiros na discussão sistemática do assunto… Para ele, o ‘experimento mental‘ é pré-condição necessária à uma… ‘experimentação física‘.

Segundo Mach, somente quando se tem uma rica experiência … a “imaginação” será capaz de auxiliar, agindo como um processo de…”purificação lógica” – através da qual é possível considerar que circunstâncias determinam certo resultado, e quais delas são dependentes, ou não, umas das outras. Nesse sentido, a natureza da experiência previamente adquirida responde pelo sucesso do E.M. – e a escolha de circunstâncias, na representação dos fatos, influencia no grau de concordância entre nossos pensamentos e as experiências. – Diz ele:

“O pensamento do físico é geralmente menos completo, do que a experiência que esquematiza. Por isso, ele descreve sua possibilidade como parte de um…método de…variação continua”. – Alargamos o ‘limite de validade‘ de uma representação, modificando e especializando as circunstâncias – dessa maneira … ‘adaptamos’ a representação. – Com o pensamento, é possível diminuir… e finalmente remover elementos com influência quantitativa no fato, para liberar outras circunstâncias.

Esse processo pode ser considerado como uma idealização, ou abstração. Mach afirma que todas as noções e leis físicas gerais foram adquiridas por idealizações. Segundo ele, pode acontecer que o resultado de uma experiência mental seja tão decisivo, que…com ou sem razão, o autor da pesquisa julgue inútil todo o controle externo da “experiência física“. Todavia, esta “necessidade” vai depender da nível de confiança do experimento mental, que aparece como sua continuação natural para completá-la e precisá-la…Para Mach…a ligação estreita entre a dedução e a experiência é a base da “ciência moderna”.

A experiência suscita um pensamento que, comparado novamente com a experiência…e a seguir modificado, constitui uma nova concepção a qual se aplica o mesmo processo. Este desenvolvimento pode absorver a atividade de diversas gerações, antes de estar completo.

Kuhn… e os “Experimentos Mentais” Para Kuhn, este método não fornece novos dados, no entanto, promove a ‘recontextualização’ de dados empíricos anteriores.

No artigo “A function for thought experiment”, de 1977 — Thomas Kuhn sugere que … a nova compreensão produzida pelos…experimentos mentais, não seria uma simples compreensão da natureza, mas…do “aparato conceitual” do cientista. – A função dos EMs seria ajudar na eliminação de um conflito – existente a priori, forçando o cientista a admitir … contradições inerentes — em sua maneira inicial de pensar. Ao contrário da “descoberta” … para um novo conhecimento — eliminar essa… “contradição” não parece exigir ‘dados empíricos’ adicionais.

No artigo “A function for thought experiment”, de 1977 — Thomas Kuhn sugere que … a nova compreensão produzida pelos…experimentos mentais, não seria uma simples compreensão da natureza, mas…do “aparato conceitual” do cientista. – A função dos EMs seria ajudar na eliminação de um conflito – existente a priori, forçando o cientista a admitir … contradições inerentes — em sua maneira inicial de pensar. Ao contrário da “descoberta” … para um novo conhecimento — eliminar essa… “contradição” não parece exigir ‘dados empíricos’ adicionais.

Kuhn afirma literalmente que os EMs não podem nos ensinar nada sobre o mundo … que não fosse conhecido antes. Entretanto, ao final do texto, o autor admite que…em algumas situações específicas, a confusão ou contradição aparente pode ser expressa pela natureza. Essa situação o leva a sugerir que…nesse tipo de experimento mental, o cientista aprende tanto sobre o mundo – quanto sobre seus conceitos. De modo análogo ao que acontece na interação entre o ‘Experimento Concreto’ (EC) realizado no laboratório e a observação do fenômeno na natureza, os EMs podem revelar falhas — pelo desacordo com os resultados esperados… – sugerindo que tanto as expectativas quanto a teoria deveriam ser revisadas.

Numa visão derivada da interpretação de Kuhn, Tamar Szabo Gendler em sua dissertação de doutorado “Sobre os Poderes e Limites do Experimento Mental” (1996) analisa os EMs como um processo de raciocínio realizado dentro do contexto de um…’cenário imaginário’ bem articulado. Seu intuito é responder a uma questão específica sobre uma situação real. Assim, segundo ela, o ‘experimento mental’ poderia revelar lacunas no sistema conceitual, e indicar um modo de fazer sua alteração; confirmando ou refutando hipóteses ou teorias:

- Um cenário imaginário é descrito;

- Um argumento que tenta estabelecer a avaliação correta do cenário é oferecido;

- Essa avaliação então é tomada — para revelar algo sobre casos além do cenário.

Para a autora, essas características tornam razoável descrever os EMs como uma modalidade do raciocínio. — Gendler sugere então… 3 tipos básicos de perguntas que podem ser feitas sobre um determinado “cenário imaginário”, e que revelam contrastes cruciais; caracterizando 3 diferentes tipos de EMs:

(1) Factível: O que aconteceria?

(2) Conceitual: Como, dado (1), nós devemos descrever o que aconteceria?

(3) Avaliativo: Como, dado (2), nós devemos avaliar o que aconteceria?

O 1º tipo diz respeito ao que pensamos acerca dos fatos de uma situação. EMs científicos são tipicamente factíveis…são tentativas de delinear ‘intuições físicas’ do que aconteceria, sob certas circunstâncias. O 2º tipo considera o que tomamos como aplicação apropriada dos conceitos, e como tal situação deve ser descrita. O 3º tipo diz respeito a uma resposta moral ou estética apropriada – ao avaliarmos o que aconteceria numa situação particular.

No laboratório mental “Experimentos mentais são executados no laboratório da mente. Além dessa metáfora é difícil dizer exatamente o que são. – Nós os reconhecemos quando os observamos… São visualizáveis … eles envolvem manipulações mentais … não são a mera consequência de cálculos fundamentados em teoria…São frequentemente (mas não sempre) impossíveis de executar como ‘experiências reais’ – seja porque nos falta a tecnologia certa – ou por serem, a princípio, simplesmente impossíveis”. (“The laboratory of mind”, Brown, 1991)

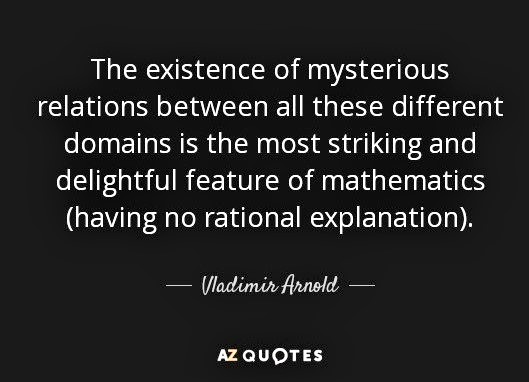

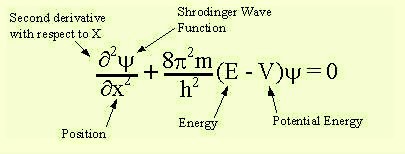

Traçando um paralelo entre o saber matemático e o conhecimento físico, James R. Brown afirma ser comum pensar a… Física – como sendo uma tentativa de descrever o mundo físico, enquanto a… Matemática – nos fornece ferramentas úteis, que envolvem o uso de…”modelos matemáticos” (‘dados a priori’) … com o objetivo fundamental de nos ajudar na teorização do… “mundo físico”.

Traçando um paralelo entre o saber matemático e o conhecimento físico, James R. Brown afirma ser comum pensar a… Física – como sendo uma tentativa de descrever o mundo físico, enquanto a… Matemática – nos fornece ferramentas úteis, que envolvem o uso de…”modelos matemáticos” (‘dados a priori’) … com o objetivo fundamental de nos ajudar na teorização do… “mundo físico”.

Mas… nosso conhecimento de um mundo físico, buscando se encaixar em determinada estrutura matemática particular é ele próprio, a posteriori, e… dessa maneira – diferente do “conhecimento matemático”…ele é falível. Porém, para o autor, a fonte primordial da “intuição matemática” … é semelhante à fonte essencial da “intuição física”.

Brown descreve alguns ingredientes envolvidos no platonismo: (1) Há ‘objetos abstratos’ existindo fora do espaço e do tempo. (2) A maneira como esses objetos são … é o que faz nossos enunciados matemáticos verdadeiros ou falsos. (3) A mente capta… ou intui algo sobre eles. (4) Nosso conhecimento matemático é verdadeiramente ‘a priori‘, no sentido de ser independente das…”sensações físicas” – todavia…não é necessariamente infalível. Assim, de forma análoga aos objetos abstratos do ‘mundo platônico‘, podemos conceber as leis naturais existindo como… “relações entre universais”. — Para o autor, há um tipo especial de EM – cuja epistemologia é similar à epistemologia matemática…que poderia fornecer a priori “crenças” (falíveis) sobre como o ‘mundo físico’ funciona. Dentro dessa perspectiva, Brown propõe uma classificação dos EMs…esquematizada na figura abaixo:

Taxonomia dos EMs, Brown (1991)

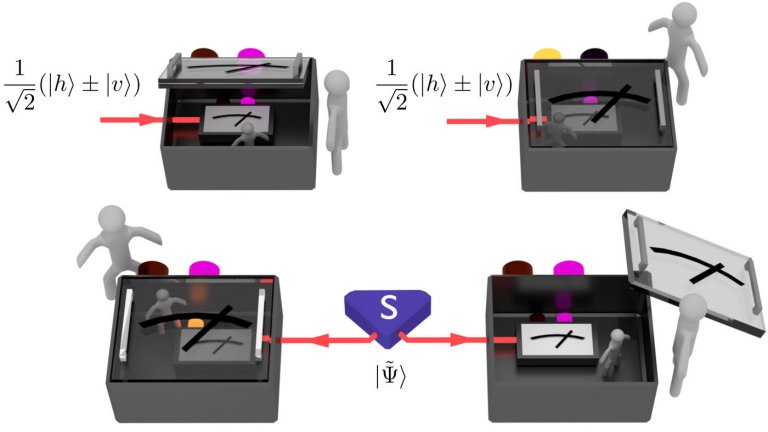

Tipicamente um ‘EM destrutivo‘ tenta mostrar que as consequências de uma determinada teoria são “absurdas”…e, por causa disso, deve ser abandonada. Por exemplo, o ‘Gato de Schröedinger’ objetiva mostrar a “incompletude“ da ‘Mecânica Quântica‘, se não existirem regras descrevendo quando a “função de onda“ colapsa. “EMs construtivos”, ao invés de refutar, fornecem suporte, essencial à elaboração de uma ‘teoria’.

Em alguns casos, contudo, o ponto de partida não será uma dada teoria a ser corroborada, mas uma situação problema: determinada conjectura, que demandará uma interpretação, nos chamados EMs construtivos ‘conjecturais’. Podemos tomar o experimento do…“Balde de Newton“…como exemplo. Já o ‘demônio de Maxwell’ é um exemplo de EM construtivo ‘mediativo’… ilustrando determinadas características da teoria. Esse EM foi utilizado para que as consequências da “teoria cinética dos gases” — em seu início … não parecessem tão absurdas. Por fim, EMs construtivos ‘diretos’… assim como os conjecturais, não começam, mas terminam, como no caso do ‘Elevador de Einstein‘…com uma teoria pronta e acabada.

Adotando, segundo ele próprio, uma visão experimentalista, James McAllister define EMs como uma forma extrema de experimento. Ele afirma que, para que um EC seja aceito como fonte de evidência, os praticantes desta ciência precisam reconhecer nele 2 critérios de legitimidade. (1) deve satisfazer os “padrões de competência” na prática experimental adotada (2) mostrar-se relevante na resolução de ‘controvérsias’. Assim, quando isso acontece – pode-se dizer que tal experimento possui…”significatividade”.

Paralelamente, EMs também devem satisfazer condições similares para serem aceitos como “fontes de evidência”. É preciso uma persuação de que o EM foi bem formulado, em concordância com padrões da ciência envolvida. Tais padrões podem por exemplo, requerer que o cenário contemplado no experimento não viole… “leis naturais” – já estabelecidas. Porém…mais fundamentalmente, os praticantes dessa ciência precisam ser persuadidos de que os EMs fornecem relevantes ‘evidências‘ – para estabelecer ou desacreditar uma afirmação. – Ou seja… também devem possuir… “significatividade”.

Modelagem cognitiva de intuições “A ‘experimentação mental’ é um modo específico de ‘simulação’, que pode ocorrer através de várias formas de raciocínio…baseadas em modelos”. (Nancy Nercessian)

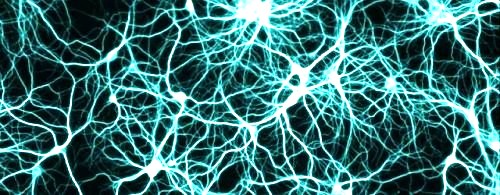

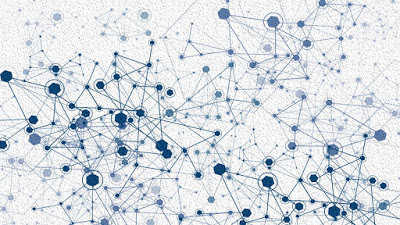

Uma linha de “interpretação alternativa” às analisadas até agora, está baseada na premissa de que… “Modelos Mentais” orientam nossos processos de ‘cognição’. Seu fundamento reside em um processo de…”modelagem cognitiva de intuições”, feito a partir de…estruturas subjacentes ao pensamento, utilizadas por nós … na interpretação do mundo ao nosso redor.

Uma linha de “interpretação alternativa” às analisadas até agora, está baseada na premissa de que… “Modelos Mentais” orientam nossos processos de ‘cognição’. Seu fundamento reside em um processo de…”modelagem cognitiva de intuições”, feito a partir de…estruturas subjacentes ao pensamento, utilizadas por nós … na interpretação do mundo ao nosso redor.

Na perspectiva da modelagem mental, a função da narrativa é guiar o leitor na construção de uma estrutura análoga à situação descrita. Em um “EM”, a narrativa tem a intenção de representar uma situação potencialmente ‘real‘. Ela possui então abstrações significativas com o objetivo de focar a atenção numa parte específica da situação; e delimitar assim, as transições específicas que a dominam. Construindo e conduzindo o experimento, fazemos uso de mecanismos de inferência…representações existentes, e conhecimentos científicos e gerais para fazer transformações realísticas – de um possível “estado físico”…para outro.

Raquel Cooper (“Thought experiments“/2005) afirma que, através de um EM, poderíamos começar de uma posição de ignorância, e obter um novo conhecimento – a despeito de não recebermos novos dados empíricos. Cooper sugere que diferenças entre modelos…mentais e concretos – podem ser insignificantes…porque, apesar das várias formas de construí-los, todos modelam a mesma ‘situação‘. – Segundo a autora, basicamente, EMs se apresentam como uma série de questões do tipo “What…if”…Por exemplo: ‘O que‘ aconteceria ‘se‘ não houvesse atrito?… — Para responder a esse tipo de questão … predizemos como ‘entidades imaginárias’ se comportariam…da mesma maneira como o fazemos para “entidades reais”.

Dessa forma, um experimentador mental manipula sua visão de mundo de acordo com questões “O que…se” propostas pelo EM. – Quando as condições necessárias de rigor e coerência são respeitadas, resultam em um modelo consistente ou uma contradição. Se um modelo consistente é ‘executado’ – o experimentador pode concluir que o cenário é possível, mas se não pode ser construído…então o cenário é impossível. Adotando uma, entre outras análises possíveis – tentaremos compreender a epistemologia dos EMs…e delinear respostas para as questões propostas… – através de 5 categorias de definições:

a) Processo de Recontextualização (Mach & Kuhn) Nessa categoria, está os que consideram que, de algum modo, a experimentação mental está ligada à experimentação concreta, num processo dinâmico de…”retroalimentação”.

Recontextualizando dados já obtidos; e/ou checando sua concordância com o mundo natural…assim, estes dados se obtêm ‘indiretamente’ da natureza, na interpretação de ‘desdobramentos’ do… “cenário imaginário”… proposto.

Recontextualizando dados já obtidos; e/ou checando sua concordância com o mundo natural…assim, estes dados se obtêm ‘indiretamente’ da natureza, na interpretação de ‘desdobramentos’ do… “cenário imaginário”… proposto.

Todos concordam que é necessário um bom conhecimento prévio do ‘comportamento natural’ para que o cientista seja bem sucedido em seu EM. – Para isso, empregam-se expressões como ‘grau de concordância’ (Mach, 1913), ou ‘critério de verossimilhança’ (Kuhn, 1977). Para Mach…a experimentação mental é parte integrante e indissociável no processo de…”construção científica”; segundo ele: “não há nenhum abismo entre a experimentação e a dedução: é uma questão de adaptar pensamentos aos fatos…e uns aos outros”. Das palavras de Kuhn: “experimentos mentais…mesmo que inteiramente apoiados em informações previamente conhecidas…possuem uma função semelhante aos experimentos reais”…Possivelmente porque dão ao cientista acesso a informações que estão em suas próprias mãos – mas…de algum modo, estiveram inacessíveis a ele.

b) Intuições Platônicas (Brown)

Essa categoria se aplica apenas à análise de Brown — na qual os EMs são … segundo ele próprio…“janelas que nos dão acesso ao mundo platônico dos objetos abstratos e relações universais”. – A categoria especifica, que Brown denomina…”EM platônico”, é capaz de fornecer – efetivamente…novos conhecimentos sobre o…”mundo natural”.

c) Argumentos Pitorescos (Norton)

Dentro da perspectiva de Norton, EMs não trazem qualquer informação sobre o mundo natural, e não transcendem o “empirismo”. – Todo o conhecimento que, supostamente, geram … está embutido em suas premissas. Não passam de argumentos disfarçados em narrativas vividas, mas podem sempre ser reconstruídos em argumentos…na vantagem de reter detalhes irrelevantes. Ele admite que, uma perspectiva acomodando os EMs ao empirismo de maneira simples e direta, deve ser aceita por definição, em comparação a uma outra proposta mais extravagante…A critica de Norton se restringe à possibilidade de novos conhecimentos, sem novos dados empíricos. O autor porém, ainda em relação a EMs, admite a possibilidade de uma exploração eficaz de modelos e imagens mentais, bem como seu poder como ‘aparato retórico’…sua similaridade à experiências reais, etc.

d) Experimentos (McAllister)

Para McAllister, EMs são experimentos…e, tal como ECs, podem fornecer aos cientistas dados sobre o mundo natural, se forem coerentemente construídos. Assim como os ECs, EMs também estão sujeitos a falhas e à má interpretação. Segundo ele, EMs não podem ser reformulados como um tipo de argumento – contrariando a definição de Norton – e possuem uma função mais geral e importante — em relação ao … “raciocínio científico”.

e) Manipulação de Modelos Mentais (Gendler, Nersessian & Cooper)

Nessa categoria, os EMs são modelados na mente, numa simulação que reproduz um cenário imaginário. Estão aqui incluídas as análises de Gendler, Nersessian e Cooper, as quais se distinguem por considerar a importância dos EMs muito mais como fonte de conhecimento sobre estruturas e concepções do experimentador — do que sobre a natureza. Similarmente à ‘recontextualização’, o conhecimento não é gerado pelo EM, mas nasce de sua interação com o mundo natural. Mesmo considerando as múltiplas interpretações e questões em aberto que envolvem esse conceito – não há dúvidas de seu valor explicativo. – A falibilidade não os denigre… Qualquer outro procedimento, experimental ou teórico, na busca de ‘razões científicas‘ está também sujeito a falhas.

Similitudes, Analogias & Aprendizagem científica Na prática, crianças aprendem a falar muito antes de escrever ou compreender as regras gramaticais – observando – estabelecendo relações … e as repetindo.

Podemos definir analogia como uma relação de equivalência entre 2 outras relações. Sua abrangência vai além do campo semântico, com variados possíveis níveis de semelhança. Analogias têm uma forma de expressão própria, em um modelo de proporcionalidade do tipo: A está para B, tal como C está para D. A habilidade de compreender similaridades e estabelecer analogias é um dos mecanismos fundamentais da…‘cognição humana’. É um aspecto crucial para o reconhecimento…classificação e aprendizagem – desempenhando importante papel na criatividade das descobertas científicas. É consenso que, apesar das diferentes definições…uma analogia é baseada em similaridades entre estruturas de dois domínios de conhecimento diferentes, um conhecido e outro desconhecido. Isto faz dela, de um modo geral…importante ferramenta na produção e transmissão do conhecimento.

Particularmente no ‘conhecimento científico’ muitas hipóteses são construídas a partir do que alguns autores chamam de ‘analogia preditiva”. Este tipo caracteriza-se por hipóteses de extrapolação: com base em uma analogia existente entre duas situações…supomos que outras relações, ainda não observadas, também se comportem de maneira análoga. Como exemplo…podemos citar o desenvolvimento da “teoria do eletromagnetismo” de Maxwell:

Nancy Nersessian propõe uma interpretação da função da “analogia física” nesse caso, onde, segundo ela, prevalece a versão de que o cientista teria chegado às equações que descrevem o “campo eletromagnético“, através de considerações de ‘simetria’ entre as equações já existentes… Leis de Coulomb, Ampère e Faraday. – De fato… Maxwell não conhecia as estruturas matemáticas que poderiam ser aplicadas — porém … através da descoberta de uma dada ‘equivalência’ entre a estrutura dinâmica de algumas relações mecânicas — e determinadas relações eletromagnéticas — ele foi capaz de construir as estruturas necessárias: o tipo de raciocínio criativo empregado na inovação conceitual, envolve não só aplicar abstrações genéricas; mas criá-las, e transformá-las…durante o processo de raciocínio. – Abstrair o nível genérico de uma mudança conceitual é etapa significativa na modelagem analógica – que pode exigir reconhecimento potencial das semelhanças em domínios díspares – a abstração…e a integração de suas informações.

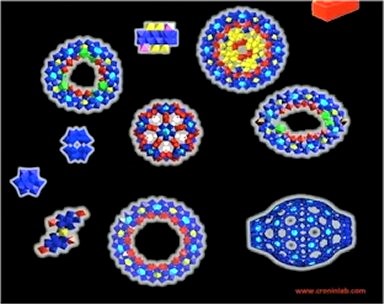

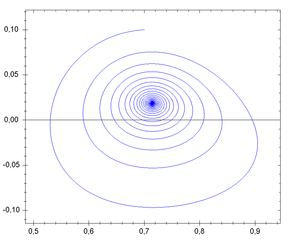

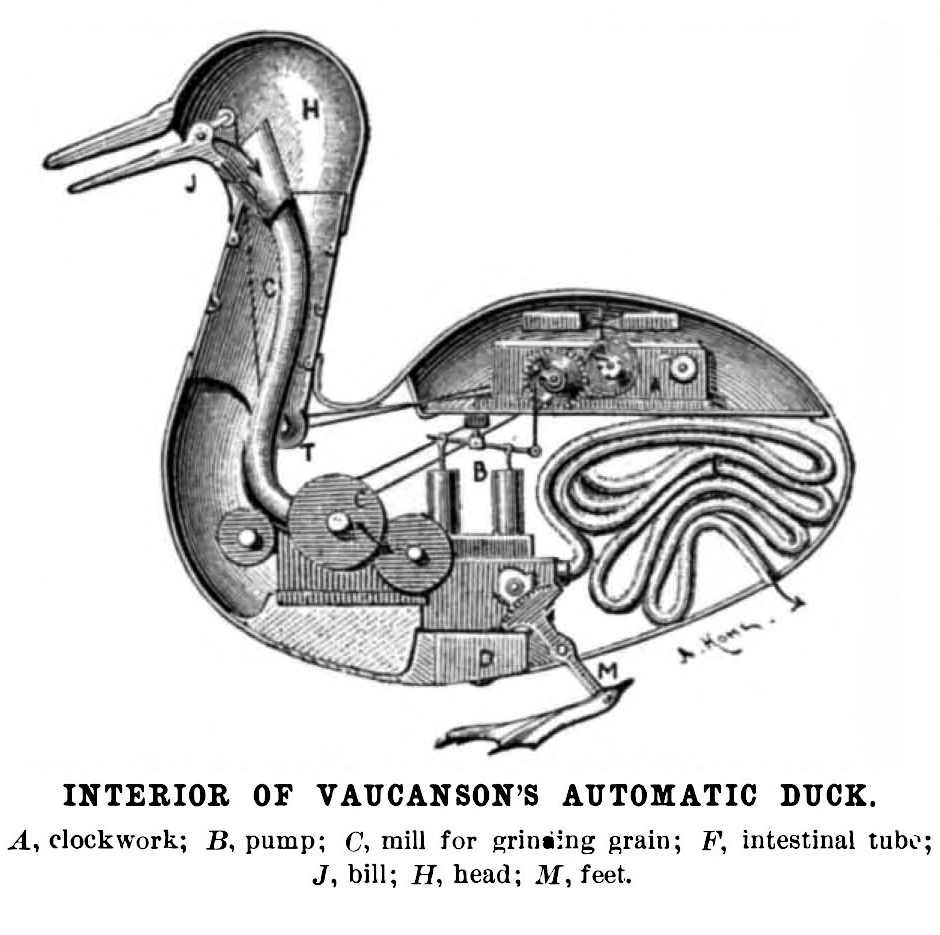

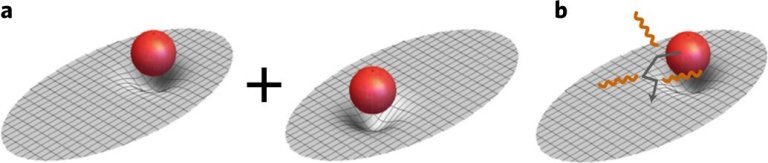

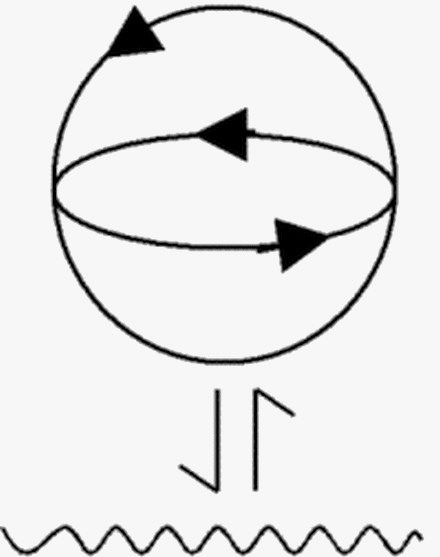

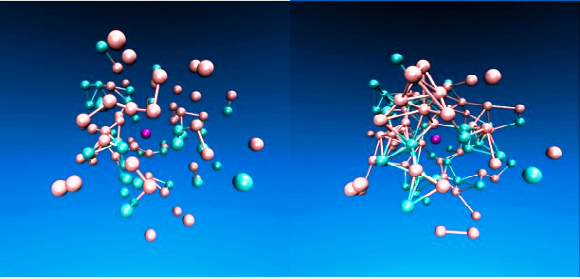

Modelo mecânico dos vórtices de éter de Maxwell

Para Nersessian o ‘avanço matemático’ adveio da… extrapolação da “analogia”. Quando Maxwell imaginou o…modelo, “fenômenos eletromagnéticos” seriam provocados pelo seu deslocamento…a rotação — seria proporcional à…’força magnética’…e o deslocamento relativo das partículas vizinhas, em magnitude e direção…se daria pela quantidade de corrente elétrica passando pelo campo.

Posteriormente sofisticou o modelo… – sistemas de vórtices agiriam como um mecanismo conectado capaz de transferir movimento elétrico … de um condutor para outro. Imaginou um mecanismo semelhante a um conjunto de catracas capazes de transferir a rotação para os vórtices vizinhos. — Para que a transferência de movimento de um vórtice a outro fosse possível supôs um éter rígido, com vórtices em rotação, e uma camada de ‘micropartículas esféricas’… capazes de rolar entre os vórtices … e, com isso … transmitir o movimento para os vórtices vizinhos. – Segundo Nersessian, esta analogia do tipo “geradora” serviu de base ao raciocínio de Maxwell – que passou a relacionar as grandezas mecânicas no movimento dos vórtices com as grandezas eletromagnéticas. – Conforme palavras do próprio Maxwell:

“É pelo emprego de analogias desse tipo que procurei colocar diante da mente, de uma forma conveniente e tratável…as ideias matemáticas que são necessárias ao estudo dos fenômenos da eletricidade. Através do método adotado espero deixar evidente que não tento estabelecer qualquer teoria física…a uma ciência na qual não fiz um experimento sequer, e que a finalidade do meu projeto é mostrar de que forma — por uma aplicação estrita das ideias e métodos de Faraday – pode-se colocar diante da mente matemática a conexão entre as diferentes ordens de fenômenos que ele descobriu”. Assim… guiado pela analogia, Maxwell interpretou a “força tangencial” das partículas, como similar ao “campo elétrico”; o momento angular dos vórtices…como equivalente à intensidade do “campo magnético”, e o movimento das partículas correspondendo à ‘corrente elétrica’.

A “Imaginação”…sob diferentes correntes epistemológicas Não há conexão direta entre a ‘origem do conhecimento‘, cujas correntes extremas são o Racionalismo e Empirismo, e a função benéfica ou prejudicial da imaginação. Racionalistas como Descartes e Spinoza ou empiristas como Bacon e Hume podem ter opiniões distintas sobre o assunto. Contudo, cabe lembrar que cada uma destas vertentes é uma tentativa de classificação que reduz algo ‘complexo’ – como a obra desses pensadores, ao só levar em consideração alguns de seus aspectos principais.

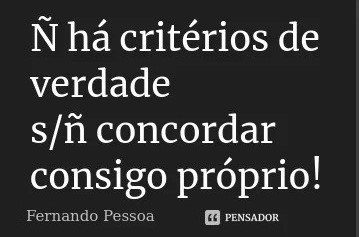

Ao considerarmos a essência do conhecimento como a busca da verdade, percebemos que, quando a verdade é uma escolha óbvia, a imaginação não oferece perigo. Por exemplo, em Descartes – para o qual o entendimento não pode ser enganado. Mas, quando a verdade é frágil, qualquer distração, como os sentidos ou imaginação, pode nos impedir de encontrá-la. Esse entendimento pode levar a posições radicais como as de Spinoza e Pascal. Mesmo dentro da supervalorizada “experiência” (característica do pensamento empirista), Bacon acreditava bastante na necessidade de disciplinar os “sentidos”, e censurar a “imaginação”.

Da opinião reiterada por vários autores é possível distinguir nesse conceito 2 faces distintas. — A “imaginação reprodutora”, associada aos sentidos…e, definida como capacidade da representação de imagens mentais, na ausência do objeto real. E…a “imaginação produtora” … poder mental de organizar imagens…recombiná-las…e fazer conexões dos sentidos, com a razão.

Da opinião reiterada por vários autores é possível distinguir nesse conceito 2 faces distintas. — A “imaginação reprodutora”, associada aos sentidos…e, definida como capacidade da representação de imagens mentais, na ausência do objeto real. E…a “imaginação produtora” … poder mental de organizar imagens…recombiná-las…e fazer conexões dos sentidos, com a razão.

Embora nem no Racionalismo ou no Empirismo a “imaginação” tenha um lugar definido, podemos observar uma ‘tendência’ criada da relação entre imaginação e sentidos. Nela, a imaginação divide o seu destino com as percepções sensíveis. Adquire assim…na obra de Aristóteles, uma participação ativa. Platão…apesar de defini-la como “faculdade inferior”, considera que a imaginação participa do conhecimento sensível como sendo responsável, junto com a crença, pela formação da ‘opinião’. Na interpretação de Hume, a imaginação tem papel fundamental na ‘transição causal’, nos assegurando a capacidade de ‘predição’, na qual se funda a ‘indução’; apesar da expectativa da repetição de eventos na associação causa/efeito, ser uma ilusão. Porém… é Kant quem marca a mudança definitiva do lugar da imaginação – que a partir daí… não mais voltaria a ser sistematicamente questionada.

Entre os representantes da moderna epistemologia, de um modo geral, todos concordam que, em algum dado momento…‘a imaginação é necessária na criação da teoria científica’; seja na elaboração das hipóteses – para Popper e Lakatos; ou…no contexto da descoberta, conforme Reichenbach. Na anarquia epistemológica feyerabendiana, em que tudo vale, o talento criador e o poder da imaginação de um determinado cientista…fazem a diferença. Mesmo na obra de Bachelard, a imaginação, que a princípio é criticada, adquire a função de ultrapassar a realidade — faculdade que nos permite o acesso a… “dimensões oníricas”.

É possível definir uma… “Imaginação Científica”? O ponto principal nessa questão é que adotar o conceito de ‘imaginação científica’ não significa distinguir um tipo específico de imaginação que atue na ciência. Ao contrário disso, significa admitir a ciência apenas como um dos modos interpretativos possíveis.

Uma teoria científica, um livro ou um quadro são criações da imaginação. Na tentativa de compreender e interagir com a realidade externa a nós mesmos, o cientista e o artista são impulsionados pelas mesmas inspirações e motivações. Para Jorge Wagensberg – o saber artístico, o científico e o “revelado”…se combinam, formando os conhecimentos possíveis, cada um com características próprias, mas sem uma hierarquia. – A ciência assim… nada mais é do que a criação de uma ficção da realidade; construída na imaginação do homem. Tudo o que é real é imaginável mas nem tudo que é imaginável é possível; e menos ainda, realizável. Ele propõe uma ‘imaginação impura‘, vinda de diferentes fontes, dentro e fora da ciência; tudo vale com as ideias, os métodos se aplicam a elas, mas obtê-las é papel da imaginação científica, através de analogias, contradição, sonho… entre outras estratégias.

A visão de Gerald Holton é menos poética, mas não menos interessante. Seu tema canaliza a imaginação do cientista – tornando-se o “artifício” através do qual observa-se a natureza. Sua “imaginação temática” tem um caráter individual…Apesar dos aspectos históricos e da influência do conhecimento compartilhado, cada cientista é personagem único … moldado por suas experiências pessoais e comprometimentos temáticos…capazes de enxergar além.

A “Imaginação” … como parte do… “Método científico” A ciência é feita das escolhas de seus protagonistas, e portanto, repleta de subjetividade. Uma teoria científica é uma ‘suposição explicativa’…e negar a influência da ‘imaginação’ como “agente ativo” na construção do conhecimento, seria – no mínimo – ingenuidade.

Embora a ciência possua regras bem definidas, seu método se limita à ‘obtenção’ e tratamento de dados. O surgimento da ideia – ou hipótese inicial é resultado do “salto intuitivo”…da livre imaginação humana. O que distingue a ciência de outras formas de interação com a realidade, é o uso do ‘método’…para obter conhecimento científico. Mas…analisando certas abordagens metodológicas, vemos mais “subjetividade” do que a maioria dos cientistas é capaz de admitir:

Embora a ciência possua regras bem definidas, seu método se limita à ‘obtenção’ e tratamento de dados. O surgimento da ideia – ou hipótese inicial é resultado do “salto intuitivo”…da livre imaginação humana. O que distingue a ciência de outras formas de interação com a realidade, é o uso do ‘método’…para obter conhecimento científico. Mas…analisando certas abordagens metodológicas, vemos mais “subjetividade” do que a maioria dos cientistas é capaz de admitir:

No argumento dedutivo, a conclusão não acrescenta nada de novo ao que já estava presente nas premissas – e só se é capaz de garantir uma conclusão verdadeira, se estas premissas são garantidamente verdadeiras. Contudo – a escolha das “premissas”… por sua vez… também é uma…”questão subjetiva”;

A indução é, de acordo com a crítica de Hume, fortemente direcionada pela “causalidade” — que por sua vez… está relacionada à… “imaginação” — que é responsável pela formação da “crença” – e também pela…”inferência causal”;

A observação isenta é uma condição inatingível…ela é sempre seletiva. Para que haja observação, é necessário um objeto escolhido a ser observado. Os cientistas obviamente escolherão aspectos da situação que convêm ao seu estudo. Além disso…há expectativas e noções prévias do que se vai observar que vão interferir na própria “observação”…que também não são imparciais – já que podem levar a uma infinidade de…”interpretações”;

A execução de experimentos envolve a elaboração do aparato experimental, que frequentemente, está direcionado ao aspecto que se deseja repetir no experimento. Todo experimento é realizado, justamente com o objetivo principal de responder a uma questão específica – previamente elaborada. Mas, há também a possibilidade da “experimentação mental” – estritamente baseada na interpretação de seu autor.

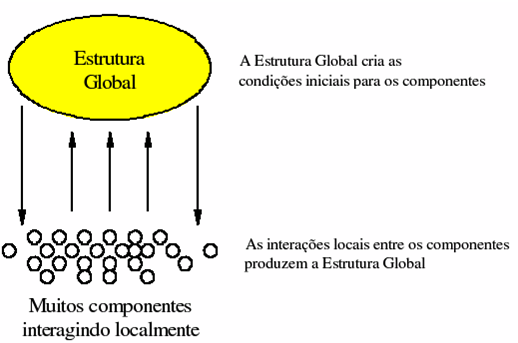

A imaginação… como capacidade que permeia todos processos cognitivos é elemento indissociável no ato da construção do…”conhecimento” – seja ele científico ou artístico, embora seu papel tenha sido muitas vezes negligenciado, sobretudo no aprendizado de novos cientistas. – Entre as muitas questões abordadas aqui este estudo, uma das mais importantes é o entendimento da imaginação … como um agente de ‘alargamento‘ dos limites do conhecimento de um dado fenômeno. Dessa forma…ela pode proporcionar a inclusão de novos elementos, aparentemente dispersos, capazes de criar novas relações conceituais e unir partes que ainda não haviam sido relacionadas – ampliando assim, a conectividade total do sistema. (Marcia Regina Santana Pereira) texto base maio/2009 ******************************(texto complementar)*****************************

Unesp lança videogame ensinando física quântica (mai/2010) “Trata-se de conceitos intrincados…que precisam ser repetidos…para que sejam assimilados. – Filmes, livros…e quadrinhos já foram feitos com tal objetivo – mas o videogame é bem mais eficaz nesse aspecto”.

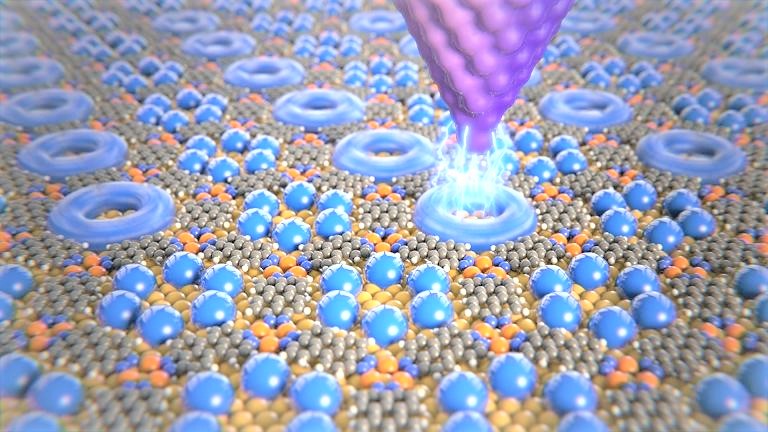

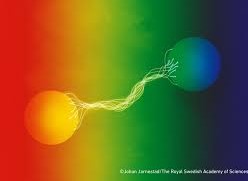

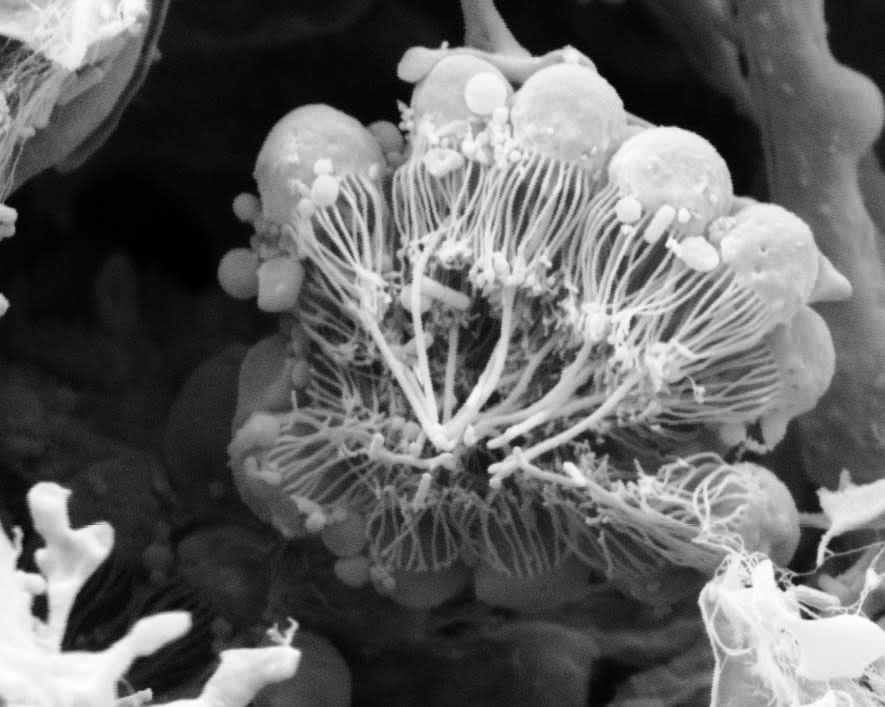

Uma espaçonave de tamanho subatômico tem a missão de capturar partículas, identificá-las – e com elas… montar ‘estruturas atômicas‘ em outro planeta. Essa é parte da missão do…‘Sprace Game’…jogo de computador projetado por físicos da ‘Universidade Estadual Paulista’ (Unesp), com o objetivo de transmitir conceitos de…”física de partículas”…para estudantes, e para o público leigo. – O professor do “Instituto de Física Teórica” da Unesp…Sérgio Ferraz Novaes… que coordena o projeto “Sprace“…contou que o jogo faz parte do esforço de levar aos alunos de ensino médio do país, informações atuais sobre a ‘física de partículas’.

Unesp lança o Sprace Game, um jogo eletrônico projetado para ensinar conceitos básicos sobre a composição da matéria, em suas partículas elementares.

Projetado em linguagem Java, o ‘Sprace Game‘ consegue rodar em qualquer computador, com sistemas operacionais Windows, Linux ou Mac. Segundo o programador do jogo…Ulisses B. de Mello… — da ‘Black Widow‘ — há 3 versões de resolução, para que máquinas — até um pouco mais antigas…possam receber o jogo; e explica: “Conseguimos rodar a versão mais básica num Pentium 1,3 Ghz em 512 Mb de memória RAM, e achamos que a ‘configuração mínima’ para o jogo seja essa”…Funcionando em ‘plataformas básicas’ o videojogo pode servir de ferramenta de ensino…a instituições carentes de recursos, só necessitando de acesso à internet…O jogo é gratuito…a partir da página “SPRACE GAME”.

As regras do Jogo “Não podíamos fazer um jogo somente divertido…mas com incorreções científicas, nem fazer algo muito preciso, mas que fosse chato de jogar”.

Experimentos realizados em aceleradores de partículas revelaram que prótons e neutrons são compostos de quarks, partes ainda menores. Além dos quarks…que se dividem em 6 tipos (up, down, estranho, charme, bottom e top), também foram descobertos os léptons (elétron, múon, tau e seus três respectivos neutrinos), e ainda…as partículas responsáveis pelas interações…forte e fraca, e a eletromagnética (glúon, W, Z e fóton), respectivamente.

Ao passar pelas 4 fases do Sprace Game, o jogador precisa capturar com sua espaçonave partículas subatômicas – levá-las a um laboratório para serem identificadas – descobrir do que são formadas as partículas compostas – hádrons – e recombinar quarks, para formar prótons e neutrons… – Com eles então…o “jogador” poderá conseguir montar núcleos atômicos de hidrogênio e oxigênio, visando obter um recurso fundamental à colonização do planeta explorado, a água. Numa das fase mais interessantes (segunda), o jogador deve encontrar, perseguir…e observar o “decaimento” da partícula tau – ou seja, sua decomposição em outras sub-partículas… – ao fim de seu tempo de vida. – São estas “sub-partículas” que o jogador deverá capturar…ajudando assim a melhor explicar o conceito de “decaimento“. Um dos grandes desafios do projeto foi criar um jogo que garantisse um bom entretenimento – sem, contudo…perder de vista a “noção científica”.

O produto final foi testado e aprovado por alunos do ‘ensino médio’…participantes do ‘Master Class Hands on Particle Physics’…evento internacional cuja etapa paulista foi realizada em fevereiro pela Unesp. Com o sucesso na escolha do jogo eletrônico como mídia para divulgar a física de partículas – o ‘Sprace Game’ tenta levar conhecimento atual para estudantes do século 21, por meio de uma mídia moderna… Enriquecê-los, com informações da… física contemporânea — é o seu objetivo principal. (texto base) ********************************************************************************

A construção (epistemológica) do conhecimento, segundo Einstein “Para Einstein, o mundo é efetivamente concebível – as leis que o físico lhe atribui, ainda que os conceitos que elas implicam sejam criações livres, não são puras convenções. E foi o sucesso da sua experiência como investigador que o levou a juntar à intuição…a criação conceitual livre, como parte obrigatória ao progresso do conhecimento”. (Merleau-Ponti)

A relação entre conceitos e o mundo sensível é aspecto importante no pensamento filosófico de Einstein…Sua concepção de não haver uma relação lógica entre estes elementos e a experiência…significa que não podemos relacioná-los simplesmente por regras objetivas…Para ele…a relação entre o “mundo racional” e o “sensorial” se dá através da “intuição”, mesmo que esta não possa ser considerada uma categoria objetiva, ou “científica”.

A relação entre conceitos e o mundo sensível é aspecto importante no pensamento filosófico de Einstein…Sua concepção de não haver uma relação lógica entre estes elementos e a experiência…significa que não podemos relacioná-los simplesmente por regras objetivas…Para ele…a relação entre o “mundo racional” e o “sensorial” se dá através da “intuição”, mesmo que esta não possa ser considerada uma categoria objetiva, ou “científica”.

A conexão de conceitos básicos do pensamento com complexos (“experiências sensoriais”) só é apreendida de modo intuitivo…não se prestando a uma determinação cientificamente lógica. Com isso, o que garante a ‘ontologia’ dos conceitos…não é a correspondência direta com a realidade, mas o fato das ideias nela elaboradas…nos orientarem corretamente. Em uma analogia simples – poderíamos afirmar que ‘conceitos’ são como um…“mapa mental”, que nos permite seguir sobre uma realidade…que permanecerá oculta aos nossos olhos. O bom da estória, está em que – apesar deste mapa ser algo bem diferente da realidade – as novas teorias emergentes … sempre estabelecem caminhos mais precisos e bem definidos. Neste sentido…a matemática assume um papel essencial – pois ela estrutura e direciona o acesso à realidade…e, quando a imaginação se submete às suas proposições, as estruturas criadas por ela podem ser legitimadas como conhecimento verdadeiro, mesmo que saindo de nossas ‘percepções sensoriais’. Assim, por tal perspectiva…a busca da fidelidade…e, em certa medida, da correspondência do saber epistêmico em relação à realidade deixa de ser ponto de partida, para ser um modo de acesso a partes do mundo, que estão ocultas a nós.

O valor que Einstein atribui às reflexões diárias o leva a considerar que a construção do saber não depende só das relações de conceitos formais da ciência — mas também…das percepções cotidianas que o indivíduo adquire em sua vivência. Isso é interessante pois mostra, mais uma vez, que a base da criação na ciência pode depender de pensamentos, ditos “comuns”…e, portanto, desprovidos de caráter científico. No entanto, estes são os alicerces do que, numa construção mais elaborada…passará a ser visto como “conteúdo científico”. Einstein, portanto, apresenta uma visão peculiar sobre a…’criação científica’, mesmo para os dias de hoje. – O “elemento chave” de sua filosofia é conseguir conciliar ambas as dimensões da racionalidade e imaginação…no trabalho de ‘criação’ na ciência.

Ao mesmo tempo em que…na construção do conhecimento fica evidente a relevância da liberdade de pensamento, e sua dimensão subjetiva (intuitiva) do mundo – fica também evidente a importância de valores ‘lógico-racionais‘ (conhecimento coerente a fim de ser compartilhado). Além disso, o objetivo da ciência como uma forma de apreensão do real não é abandonado… Mesmo admitindo que o ‘pensamento abstrato’ não se corresponda diretamente com a realidade a ser compreendida; não deixa de ser a forma mais fiel que temos para lidar com ela. – Enquanto coloca-se à prova o…”pensamento”, como guia de nossa relação com o…”mundo exterior” – seu desenvolvimento permanece em aberto, a etapas de diferentes naturezas – confrontando-se de diversas maneiras com a realidade.

Einstein valoriza muito as impressões subjetivas, sobretudo as baseadas no pensamento ainda não conceitual. Esse fator corresponde ao que denominamos como…”imaginário”: “campo simbólico” no qual o pensamento opera. Esta “primeira impressão” nos permite refletir sobre o modo como concebemos determinadas formas de aprendizado…É muito comum…por exemplo, que experiências no campo didático busquem ser demonstrações de fenômenos. Porém, por mais que isto tenha algum tipo de validade à prática docente, a criação individual reside muito mais numa apreensão subjetiva da realidade — do que na busca de uma representação fiel da mesma. Nesse sentido…podemos considerar que estratégias que valorizem/explorem alguma determinada ‘forma subjetiva de percepção’ possam exercer uma prévia função na busca da formalização conceitual de certas ideias.

(texto base) Ivã Gurgel e Maurício Pietrocola (mar/2021) *****************************************************

O fio de Ariadne: imaginação, ciência e arte (Patrícia Fonseca Fanaya)

A ‘imaginação‘ exerce papel determinante na influência mútua que as ciências e a arte têm uma sobre a outra, sendo esta uma discussão antiga na filosofia… que teve início na Grécia. A ideia de… “mimesis” — para os gregos, se relacionava com…representação da natureza, o que certamente incluía a natureza humana.

A ‘imaginação‘ exerce papel determinante na influência mútua que as ciências e a arte têm uma sobre a outra, sendo esta uma discussão antiga na filosofia… que teve início na Grécia. A ideia de… “mimesis” — para os gregos, se relacionava com…representação da natureza, o que certamente incluía a natureza humana.

Platão escreveu sobre ‘mimesis’ no ‘Íon’…e livros II, III e X de A república. Para ele…a arte imitava a vida; ideia que logo aparecia refletida nas narrativas míticas do período.

Aristóteles, por outro lado, considerava “mimesis” como a imitação de uma ação. Em sua “Poética” – obra filosófica de suma importância para a história do pensamento e à crítica literária, ele nos diz que, para além de uma mera imitação, a mimesis é uma ação que, ao mesmo tempo que reproduz o real, o supera, aprimora, modifica, e desse modo…recria-o.

David Hume, o importante filósofo empirista do iluminismo, conhecido e reconhecido não só por seu empirismo radical, mas também por sua prosa elegante, defendia que a imaginação é uma faculdade mental que forma…une e distingue as ideias. Tal atributo criativo da imaginação coloca-a em posição de desempenhar papel fundamental, tanto na ficção, como nas ‘ciências naturais‘. É através da imaginação que somos capazes de criar mitos…como Prometeu ou Dédalo; personagens como Hamlet…ou Frankenstein; ou ainda de inventar a matemática, e a partir dela calcular a distância entre as estrelas.

Outro filósofo que se ocupou em pensar e escrever sobre a imaginação foi Kant. Na sua “Crítica da faculdade de julgar” (1790), Kant trata a imaginação não como uma faculdade da ilusão – mas como poderosa ‘faculdade criativa’ … capaz de ‘reformar a natureza’. A ‘liberdade imaginativa’, para ele, ocorre quando julgamos um objeto de forma totalmente desinteressada…permitindo assim, que a imaginação brinque livremente com formas que se revelam à ‘percepção’, ou ocorre de modo produtivo no artista, quando usada para produzir/exibir…’ideais estéticos’: intuições íntimas eventuais – que estimulam o pensamento … sem serem captadas discursivamente. É pela imaginação, pensa Kant…que somos capazes de tomar o que a natureza nos dá, e transformar isso em…”outra natureza”. Como seres físicos, estamos presos às leis da natureza – como agentes morais, estamos presos à lei da razão prática; mas, como…”criaturas imaginativas” … não somos limitados em nosso…”poder criativo”.

Darwin também escreveu sobre o poder da imaginação. Em…“The descent of man, and selection in relation to sex” (1871), diz ele: “a imaginação é uma das mais altas prerrogativas do homem. Através dessa faculdade ele une imagens e ideias prévias, livres da vontade, e assim cria resultados inovadores”; como diz Jean Paul Richter: “sonhar nos dá a melhor noção desse poder como uma involuntária arte da poesia”.

Assim como Ariadne ajudou a salvar Creta ao conduzir Teseu à saída do labirinto do Minotauro…fazendo-o entender que o ponto de partida era também o de chegada, a imaginação parece ser o fio que devemos seguir para entender que ‘a ciência e a arte são traços complementares da experiência humana de estar no mundo e gerar saber’. Numa época como a nossa…onde até mesmo o processo de ‘seleção natural’ já pode ser substituído pela…’técnica’…necessitaremos transformar profundamente a nossa maneira de compreender e lidar com a “natureza humana”. Precisaremos…cada vez mais, enfrentar com coragem e imaginação…as perguntas cruciais…sobre o que nos faz humanos, sobre-humanos, não-humanos ou inumanos. (texto base – mar/2020)

O tema em torno da

O tema em torno da

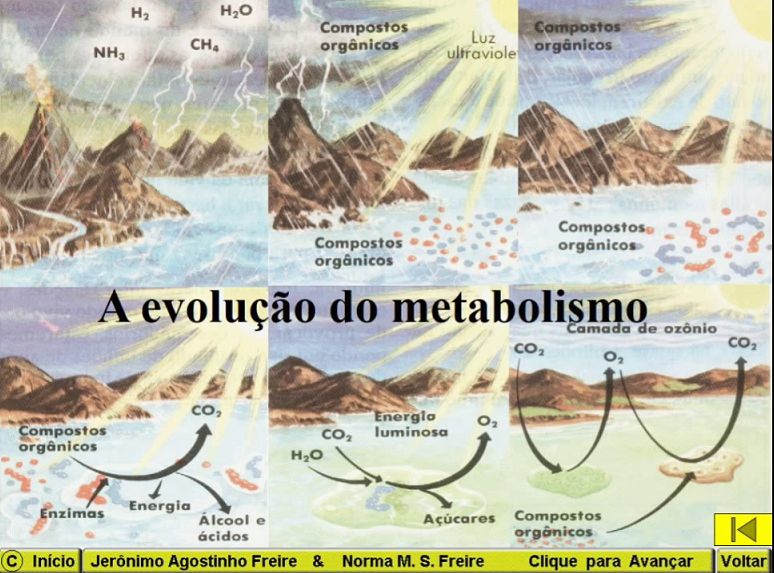

Teoria biológica da ‘Autorganização’

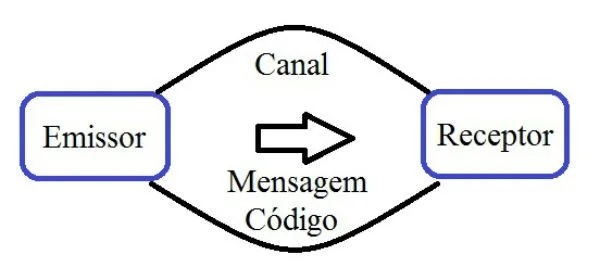

Teoria biológica da ‘Autorganização’  A proposta de Atlan é simples…Imagine uma fonte de comunicação e um receptor…ambos dentro de uma célula

A proposta de Atlan é simples…Imagine uma fonte de comunicação e um receptor…ambos dentro de uma célula

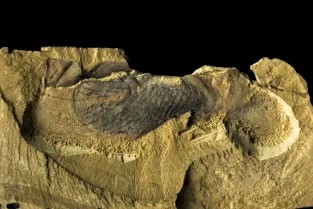

“Elo perdido”

“Elo perdido”

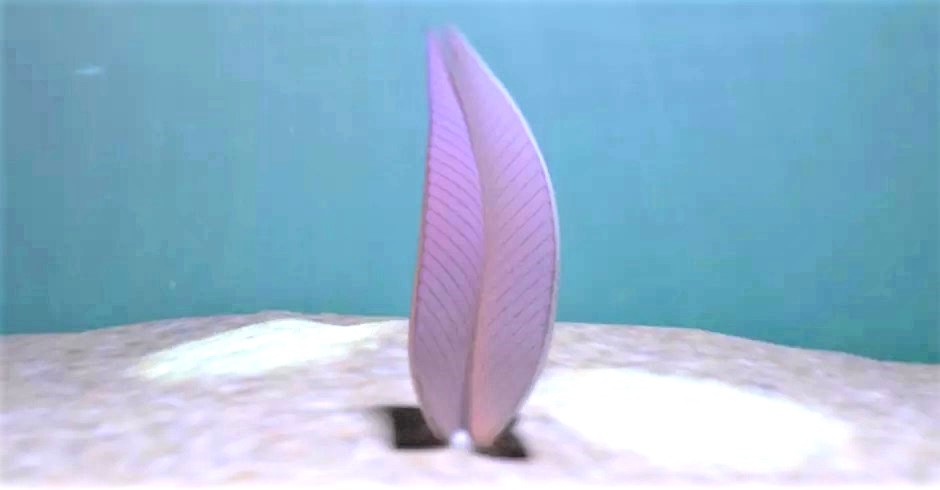

Breve gênese do Sistema Solar

Breve gênese do Sistema Solar

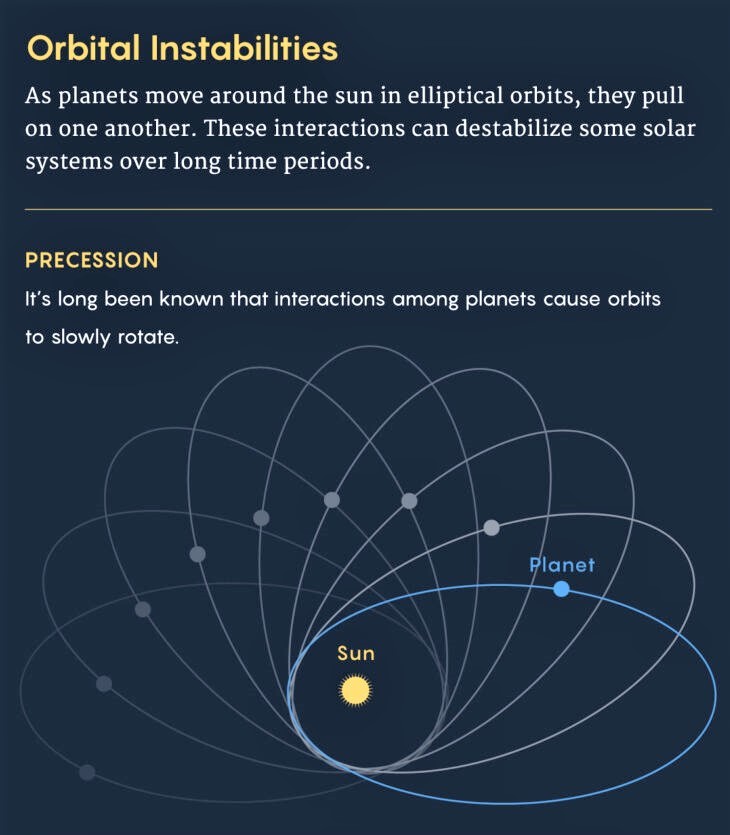

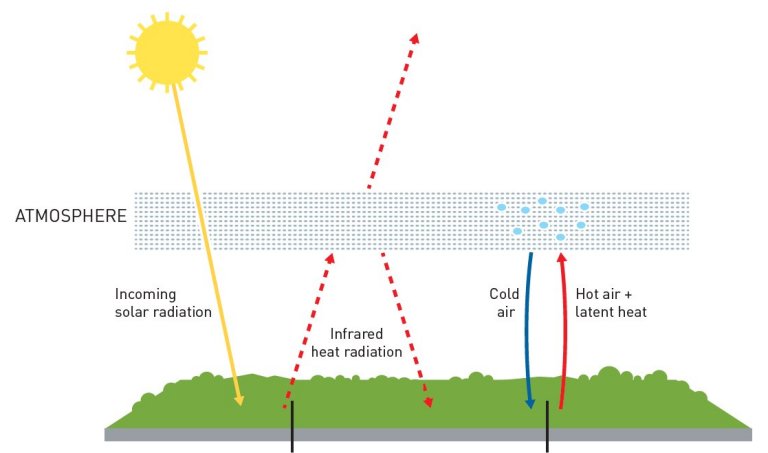

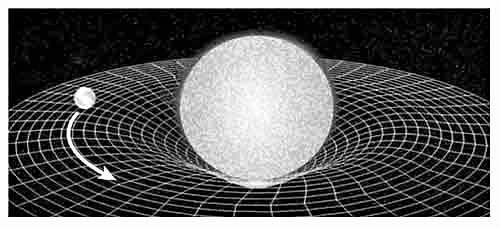

Há séculos…já se sabia, que interações entre planetas poderiam ter ‘efeitos de longo prazo‘… — Considere Mercúrio: gasta cerca de 3 meses para completar sua… órbita elíptica – em torno do sol, mas esse caminho também gira – bem lentamente: um grau a cada 600 anos, uma rotação completa a cada 200 mil. Esse tipo de rotação…dito “precessão”, se deve, em grande parte, a um puxão gravitacional de Vênus, Terra, Júpiter. Entretanto… – pesquisas no século 18 realizadas por “gigantes matemáticos” como Laplace e Lagrange…indicaram, precessão à parte – tanto a…forma da elipse quanto tamanho como estáveis.

Há séculos…já se sabia, que interações entre planetas poderiam ter ‘efeitos de longo prazo‘… — Considere Mercúrio: gasta cerca de 3 meses para completar sua… órbita elíptica – em torno do sol, mas esse caminho também gira – bem lentamente: um grau a cada 600 anos, uma rotação completa a cada 200 mil. Esse tipo de rotação…dito “precessão”, se deve, em grande parte, a um puxão gravitacional de Vênus, Terra, Júpiter. Entretanto… – pesquisas no século 18 realizadas por “gigantes matemáticos” como Laplace e Lagrange…indicaram, precessão à parte – tanto a…forma da elipse quanto tamanho como estáveis.

“Ressonâncias” de Poincaré

“Ressonâncias” de Poincaré

O “eterno retorno” em um breve resumo

O “eterno retorno” em um breve resumo A novela “Memórias do subsolo” foi toda escrita por Fiódor Dostoiévski (1821-1881) entre janeiro e maio de 1864, em Moscou – enquanto caía sobre a cidade um pesado inverno, e no aposento ao lado, morria a mulher do escritor – por tuberculose. No monólogo, um aposentado parece estar voltado apenas para si mesmo…mas na verdade dialoga com o mundo…ou, o mistério da ‘existência humana’. — Na 1ª parte do livro, ele duvida de todas certezas – enquanto tenta disfarçar a sua ansiedade – ante tantas alternativas.

A novela “Memórias do subsolo” foi toda escrita por Fiódor Dostoiévski (1821-1881) entre janeiro e maio de 1864, em Moscou – enquanto caía sobre a cidade um pesado inverno, e no aposento ao lado, morria a mulher do escritor – por tuberculose. No monólogo, um aposentado parece estar voltado apenas para si mesmo…mas na verdade dialoga com o mundo…ou, o mistério da ‘existência humana’. — Na 1ª parte do livro, ele duvida de todas certezas – enquanto tenta disfarçar a sua ansiedade – ante tantas alternativas.

Apesar da peça ter arrebatado o público com uma crítica social e política muito intensa, desde a sua estreia no século 19…até os dias de hoje, tal efeito não era o objetivo de Gógol, muito pelo contrário, sua pretensão era um tanto modesta… O escritor, meio conservador e simpatizante do Czar, queria mostrar numa comédia leve, o cotidiano ridículo de uma pequena cidade – no interior…da Rússia:

Apesar da peça ter arrebatado o público com uma crítica social e política muito intensa, desde a sua estreia no século 19…até os dias de hoje, tal efeito não era o objetivo de Gógol, muito pelo contrário, sua pretensão era um tanto modesta… O escritor, meio conservador e simpatizante do Czar, queria mostrar numa comédia leve, o cotidiano ridículo de uma pequena cidade – no interior…da Rússia:

Muitas vezes… “o fogo ficou órfão — para alegria da eternidade”. Estão aí a ‘Eneida‘ e ‘Lolita’, separadas por mais de 20 séculos – mas irmanadas mais além de toda beleza literária pelas…”chamas infrutíferas” prometidas por seus próprios autores … e naquelas pelas quais…em vão, foram ameaçadas, por alguns daqueles autonomeados…“guardiões das ideias políticas, religiosas, sociais, éticas e morais“.

Muitas vezes… “o fogo ficou órfão — para alegria da eternidade”. Estão aí a ‘Eneida‘ e ‘Lolita’, separadas por mais de 20 séculos – mas irmanadas mais além de toda beleza literária pelas…”chamas infrutíferas” prometidas por seus próprios autores … e naquelas pelas quais…em vão, foram ameaçadas, por alguns daqueles autonomeados…“guardiões das ideias políticas, religiosas, sociais, éticas e morais“.

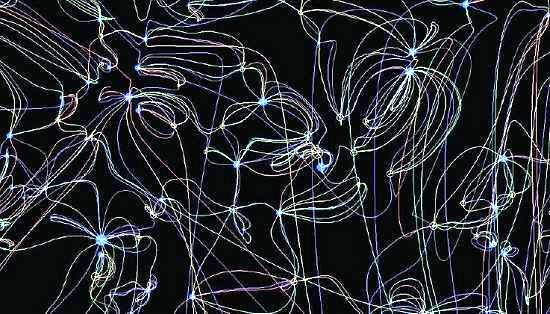

Auto-organização em processos dinâmicos

Auto-organização em processos dinâmicos

Estruturas de Feedback

Estruturas de Feedback

Sobrevivência e Uniformidade

Sobrevivência e Uniformidade

O que é “teoria do conhecimento“?

O que é “teoria do conhecimento“?  Critérios de ‘verdade’…e ‘extensão’

Critérios de ‘verdade’…e ‘extensão’

Da filosofia para a ciência

Da filosofia para a ciência Teorias científicas & ‘Processo filosófico’

Teorias científicas & ‘Processo filosófico’

Paradoxo quântico-filosófico

Paradoxo quântico-filosófico

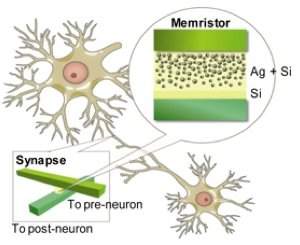

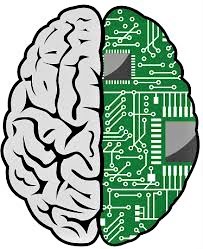

“Computação cognitiva”

“Computação cognitiva”

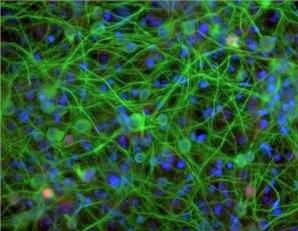

Todos sonhamos com o controle de aparelhos apenas pelo pensamento…sobretudo aquelas pessoas com ‘deficiências físicas’. — Embora no estágio atual estas tecnologias ainda estejam bem aquém dos nossos sonhos – é verdade que as interfaces ‘cérebro–computador’ podem fazer muito mais; na verdade…não sabemos bem os limites da sua aplicação. E, como há muita gente trabalhando nisso…cedo ou tarde essas conexões informática/cérebro se tornarão realidade; o que exige de fato que se discuta com antecedência todas implicações éticas, legais…e sociais dessa nova tecnologia.

Todos sonhamos com o controle de aparelhos apenas pelo pensamento…sobretudo aquelas pessoas com ‘deficiências físicas’. — Embora no estágio atual estas tecnologias ainda estejam bem aquém dos nossos sonhos – é verdade que as interfaces ‘cérebro–computador’ podem fazer muito mais; na verdade…não sabemos bem os limites da sua aplicação. E, como há muita gente trabalhando nisso…cedo ou tarde essas conexões informática/cérebro se tornarão realidade; o que exige de fato que se discuta com antecedência todas implicações éticas, legais…e sociais dessa nova tecnologia.

1. Teoria geral de sistemas

1. Teoria geral de sistemas  2. Autopoiese

2. Autopoiese

4. Teoria do Caos

4. Teoria do Caos

Nesse sentido, a explicação deve procurar entender o processo recorrente, cujos produtos, ou efeitos finais, geraram seu próprio recomeço. Isso nos traz de volta um conceito de ‘caráter paradigmático’ – central nas formulações de Morin… – o de ‘organização’

Nesse sentido, a explicação deve procurar entender o processo recorrente, cujos produtos, ou efeitos finais, geraram seu próprio recomeço. Isso nos traz de volta um conceito de ‘caráter paradigmático’ – central nas formulações de Morin… – o de ‘organização’

É comum se pensar que o aprendizado envolve uma certa… ‘intencionalidade’, um determinado propósito. — Isso… a princípio se justificaria, ao pensarmos que…em todo comportamento…o que importa são suas consequências…Mas, isto é um grande erro… —

É comum se pensar que o aprendizado envolve uma certa… ‘intencionalidade’, um determinado propósito. — Isso… a princípio se justificaria, ao pensarmos que…em todo comportamento…o que importa são suas consequências…Mas, isto é um grande erro… —  A “alterpoiese” aqui aventada não é um conceito substitutivo ou complementar ao de ‘autopoiese’.

A “alterpoiese” aqui aventada não é um conceito substitutivo ou complementar ao de ‘autopoiese’.

“Teleologia” (a ciência da “finalidade”)

“Teleologia” (a ciência da “finalidade”)